どくとりん

@docto_rin

Medical Student (B5) at Nagoya Univ. | Part-time Engineer @PreferredNetJP

Our new preprint is out on arXiv! We built MedRECT, a medical reasoning benchmark to study how LLMs detect, localize, and correct errors in clinical texts. Paper: arxiv.org/abs/2511.00421 Code: github.com/pfnet-research…

"Reinforced"

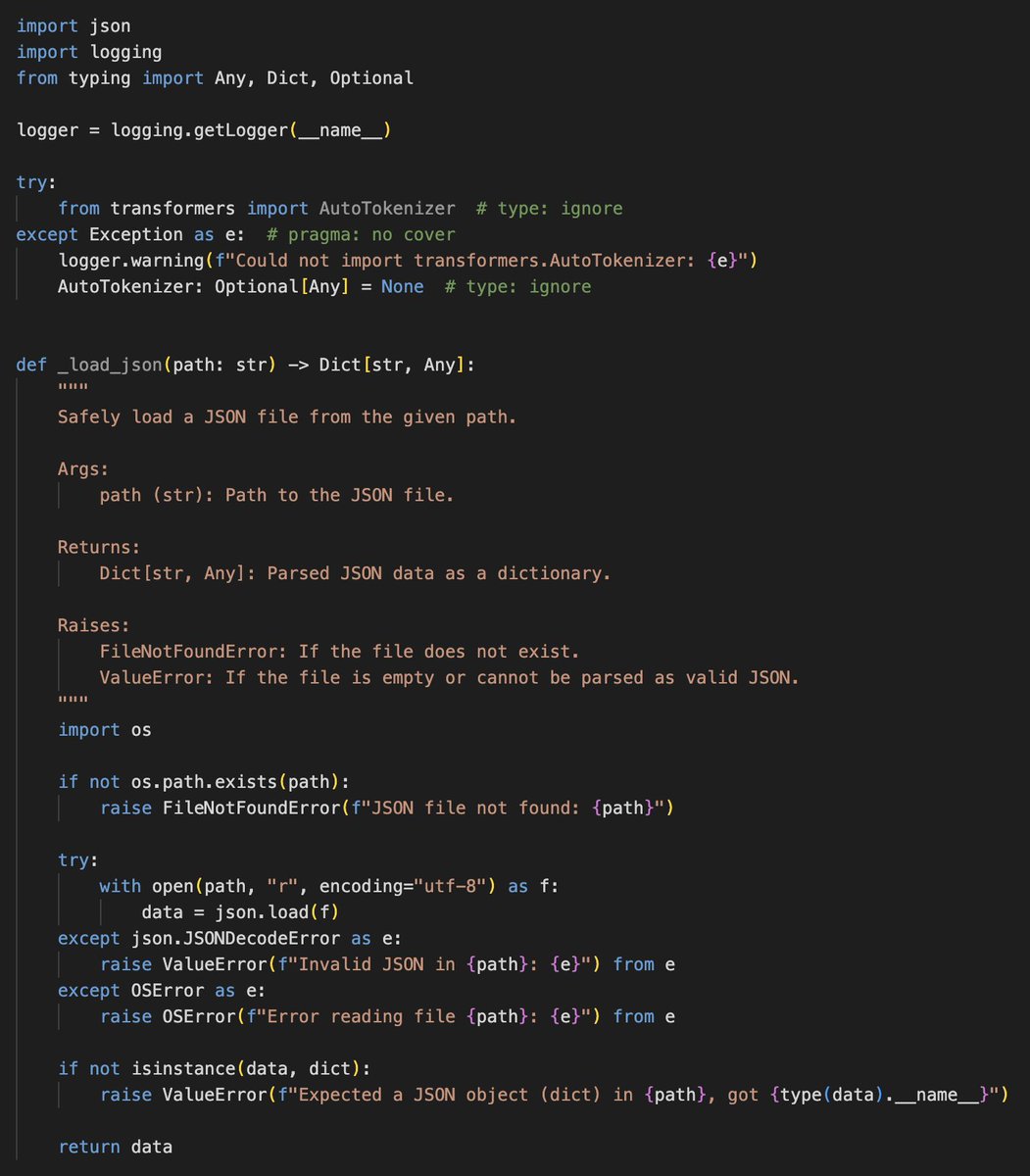

This code is extremely dangerous. Here, I improved it.

Paper2Agent: Reimagining Research Papers As Interactive and Reliable AI Agents Stanfordより 論文のコードと手順をMCPサーバーとしてtool callableにし、Claude Codeなどを用いて対話しながら実験再現や応用が可能に AlphaGenome、Scanpy、TISSUEなどがtoolとして搭載 arxiv.org/abs/2509.06917

MedResearcher-R1 医療特化 Deep Research。 1. PubMedから、希少疾患も重視した知識グラフを構築 2. 臨床権威性と鑑別診断を両方加味した検索エンジン 3. SFT+RLで堅牢な医療推論能力を獲得 MedBrowseCompでo3 Deep Researchを倒してSOTA。 一般タスクでも競争力のある成績。 arxiv.org/abs/2508.14880

コード実行型エージェントのためのRL 可変時間行動に対する時間重み付き勾配+進捗ログへの部分報酬により、勾配更新が速い方法の過剰評価を防ぎ、軽微な失敗も適切に評価。 Qwen2.5-3Bに適用し、Claude-3.5-Sonnet + agent scaffoldsに対しKaggleの12課題で平均+22%。 arxiv.org/abs/2509.01684

pre-eclampsia の和訳は昔は子癇前症を当てていたけど、最近では妊娠高血圧腎症だよという話を産科の授業で聞きました google翻訳、DeepL、gpt-5-thinking、gemini-2.5-proに和訳させてみたらいずれも子癇前症と答えててなるほどなぁとなりました。医学用語の翻訳は難しい

時代は Daniel Han なんよ

GPT-OSS bug fixes + Flex Attention support is here! 1. Fixed float16 infinite losses (>65504 overflows) 2. SWA=128 Flex default uses 129 tokens (extra 1) 3. Fixed MXFP4 inference swiglu_limit=7.0 not set 4. Sink token moved to index 0 5. FA3 doesn't have attn sink dX Details:…

- 元の8倍以上のコンテキスト長でも単一GPU(80GB VRAM)で学習可能に - モデルロード時、expertをmxfp4のまま保持可能に - 学習後、mxfp4をon demand dequantizationしながらlora adapterとマージし、bf16でexport可能に - bf16未対応GPU上で損失が発散するバグを修正 やっとインフラ整備されてきた

OpenAI gpt-oss with ultra long context is here!🚀 Introducing Unsloth Flex Attention which enables 61K context for gpt-oss bf16 training on a 80GB GPU. Unsloth achieves 8×longer context, 50% less VRAM & 1.5×faster training vs. all implementations. 🔗docs.unsloth.ai/basics/long-co…

このたび7月から、Preferred Networks (@PreferredNetJP) の医療用 LLM チームでパートタイムエンジニアとして働かせていただくことになりました! 医学生としての視点も活かしながら、医療分野における AI 技術の発展に貢献できるよう、精一杯頑張ります。 どうぞよろしくお願いいたします!

Microsoftと中国のチームが提唱する新手法「Reinforcement Pre-Training (RPT)」。 従来の「次トークン予測」を、報酬付きの「次トークン推論」として再定義する試み。 アライメント用の強化学習(GRPO)を事前学習に導入し、モデルの根源的な推論能力向上を達成。 論文: arxiv.org/abs/2506.08007

【入門】フローマッチングのエッセンスzenn.dev/doctorin/artic… 前回投稿した「【入門】拡散モデルのエッセンス」に引き続き、フローマッチングの数理をまとめました。備忘録

arxiv.org/abs/2506.00711 画像 (1D/2D/3D)・時系列信号 (ECG)・テキストを統合する初のオープン臨床基盤モデル。 Domain-AwareなGRPOでデータ不均衡を緩和し、ドメイン希少性や難易度に応じて報酬を調整。 診断性能(平均F1で43%向上)と解釈性(顕著領域IoUの精度はo4-miniに匹敵)を大幅に改善した。

How can we make genomic foundation models actually useful to biology?! Teach them to REASON!! 🧬 Excited to share BioReason - the first model to successfully integrate DNA foundation models (eg, Evo 2) with LLMs (eg, Qwen3) for biological reasoning! 🔬 What we built: • Novel…

United States Trends

- 1. $APDN $0.20 Applied DNA N/A

- 2. $SENS $0.70 Senseonics CGM N/A

- 3. $LMT $450.50 Lockheed F-35 N/A

- 4. yeonjun 268K posts

- 5. #CARTMANCOIN 1,966 posts

- 6. Broncos 68K posts

- 7. Raiders 67.3K posts

- 8. #iQIYIiJOYTH2026 1.31M posts

- 9. Bo Nix 18.7K posts

- 10. Geno 19.4K posts

- 11. daniela 56.2K posts

- 12. Kehlani 11.6K posts

- 13. #Pluribus 3,167 posts

- 14. Sean Payton 4,887 posts

- 15. #PowerForce 1,068 posts

- 16. #NOLABELS_PART01 115K posts

- 17. Danny Brown 3,348 posts

- 18. John Wayne 1,103 posts

- 19. Tammy Faye 1,703 posts

- 20. Kenny Pickett 1,528 posts

Something went wrong.

Something went wrong.